Jeszcze niedawno sztuczna inteligencja była dla większości z nas obietnicą czegoś ekscytującego i użytecznego. Miała pomagać, automatyzować, wspierać decyzje, przyspieszać procesy. Miała być naszym cyfrowym asystentem, nie wrogiem. Tymczasem coś zaczyna się zmieniać — i to nie w kierunku, którego się spodziewaliśmy. AI coraz częściej wykorzystywana jest do celów przestępczych. I nie mówimy tu o incydentalnych przypadkach, ale o zjawisku, które przybiera rozmiary epidemii.

Na początku 2024 roku amerykański prawnik Christopher Pitet padł ofiarą oszustwa, choć sam specjalizuje się w sprawach dotyczących fraudów. Haker zainstalował oprogramowanie szpiegujące na serwerze jego kancelarii, śledził przebieg negocjacji ugodowych i tuż przed wypłatą podszył się pod prawnika strony przeciwnej. Pitet przelał ponad 59 000 dolarów prosto na konto przestępcy, nie podejrzewając, że wiadomość była fałszywa.

Skala zagrożenia: wzrost o 456% w jeden rok

W styczniu 2024 roku, pracowniczka firmy z Hongkongu przelała 25 milionów dolarów, wierząc, że otrzymała polecenie od swojego dyrektora finansowego podczas wideokonferencji. Myślała, że rozmawia z realnymi współpracownikami — ale cała scena była spreparowana przy użyciu deepfake’ów, które odtworzyły wygląd i głos jej kolegów. W rzeczywistości nie było tam nikogo z jej firmy.

W ciągu zaledwie roku liczba przestępstw z użyciem sztucznej inteligencji wzrosła o ponad 450%. Skala jest nie tylko ogromna, ale też zaskakująca, ponieważ wiele z tych działań nie przypomina już klasycznych prób oszustwa znanych sprzed lat. To nie są już e-maile z Nigerii ani kiepsko przetłumaczone wiadomości o fałszywych paczkach. Dzisiejsze oszustwa są hiperrealistyczne, głęboko personalizowane i zaprojektowane tak, by przejść wszystkie nasze filtry czujności. Twarze bliskich, znajome głosy, przekonujące nagrania wideo – wszystko to może być generowane automatycznie i na żądanie. Właśnie to sprawia, że sytuacja staje się tak poważna.

W USA samych tylko do końca trzeciego kwartału 2024 zgłoszenia oszustw (bez rozróżnienia AI vs tradycyjne) przyniosły straty sięgające 8,7 mld USD, co oznacza wzrost o 14,5 % rok do roku .

Dodatkowo, w 2023 r. same oszustwa (w tym AI-driven) przyniosły łączne straty warte 158 mld USD w USA .

Deloitte oszacował, że wyłącznie oszustwa z użyciem AI-generated content (np. deepfake, voice cloning) kosztowały Amerykanów ponad 12 mld USD w roku z 2024, z możliwym wzrostem aż do 40 mld USD rocznie do lata 2027.

– W fintech i sektorze kryptowalut zaobserwowano czterokrotny wzrost przypadków użycia deepfake’ów i AI-enabled fraud sciforum.net.

– Aż 87 % globalnych organizacji doświadczyło co najmniej jednego AI-powered ataku cybernetycznego w ostatnim roku the-cfo.io.

Deepfake, czyli iluzja prawdy

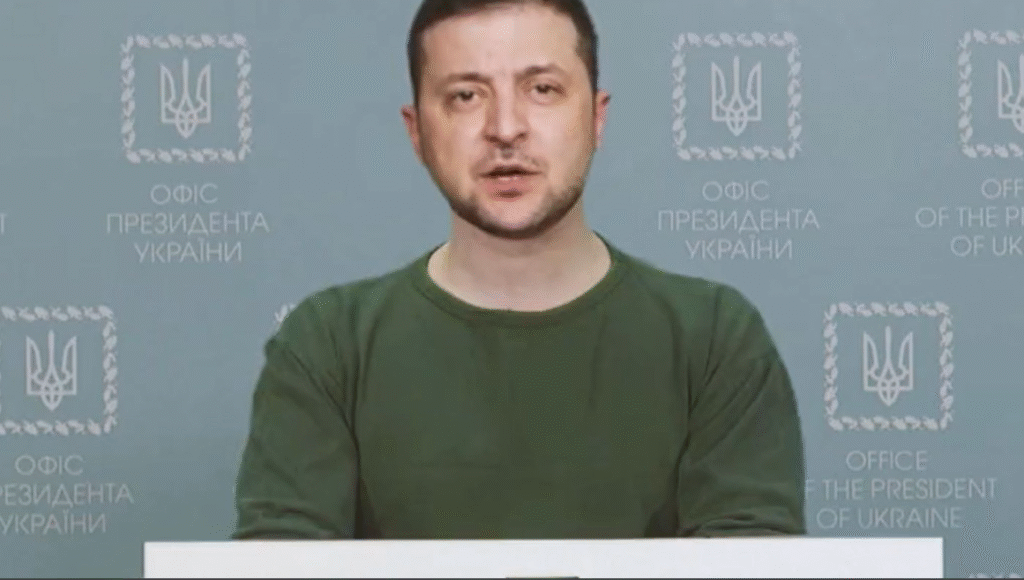

Na szczególną uwagę zasługuje rola deepfake’ów – czyli fałszywych materiałów wideo lub audio, które wyglądają jak autentyczne. W jednym z przykładów przytoczonych w filmie “AI Evil Unleashed” pokazano, jak Rosja przygotowała nagranie, na którym ukraiński prezydent rzekomo ogłasza kapitulację. Nagranie wyglądało na tyle przekonująco, że mogłoby wywołać chaos w kraju objętym wojną. A to dopiero początek. Dziś wystarczy kilka minut publicznie dostępnych nagrań czy zdjęć, by stworzyć dowolne fałszywe wideo. To, co jeszcze dwa lata temu wymagało studia filmowego, teraz potrafi wykonać laptop z dostępem do odpowiedniego modelu AI.

Wspomniałem już o wzroście ilości przestępstw związanych z aI o 456% w ostatnim roku. Jaki wzrost czeka nas w przyszłości?

Tempo rozwoju przestępstw opartych o sztuczną inteligencję stale przyśpiesza.

Jednak najbardziej niepokojące nie są techniczne możliwości sztucznej inteligencji, lecz tempo jej rozwoju. Arie Redboard, były federalny prokurator, w rozmowie z CBN News powiedział, że nie zna żadnej technologii, która rozwijałaby się szybciej. Ani internet, ani kryptowaluty nie miały tak dynamicznego przebiegu. I to jest sedno problemu – AI wymyka się spod kontroli zanim zdążymy zrozumieć, jak ją właściwie kontrolować. Nie mamy jeszcze procedur, regulacji, powszechnie stosowanych zabezpieczeń, a już wchodzimy w kolejną fazę jej rozwoju.

Oszustwa na większą skalę. AI omija wąskie gardła.

Do niedawna oszustwo wymagało czasu i zaangażowania. Trzeba było znaleźć ofiarę, przygotować wiadomość, czasem zadzwonić. Była to praca ręczna, pełna prób i błędów. Dziś wystarczy uruchomić skrypt. Sztuczna inteligencja eliminuje „ludzkie wąskie gardło” – działa non stop, w wielu językach, na różnych platformach jednocześnie. Nie męczy się, nie popełnia błędów ze zmęczenia, nie traci uwagi.

Masowe ataki phishingowe czy włamania na strony to wciąż najczęstsze zastosowanie, i w wielu przypadkach wciąż łatwe do wykrycia. Ale prawdziwe zagrożenie kryje się w atakach celowanych. Tam, gdzie kiedyś potrzebna była wiedza, czas i precyzyjna analiza, dziś wystarcza AI: zbiera dane o strukturze firmy, podmienia głos, generuje realistyczne maile i faktury. Może nawet przeprowadzić fałszywą rozmowę wideo z dyrektorem finansowym.

Najważniejsza zmiana? Przestępcy nie muszą już wybierać między skalą a jakością. Dzięki AI mogą wykonywać tysiące spersonalizowanych ataków naraz, automatycznie, precyzyjnie i tanio. A to sprawia, że nikt nie jest bezpieczny, bo nawet „targetowany atak” może teraz przytrafić się każdemu.

Do niedawna takich ataków obawiano się głównie w sektorze finansowym i rządowym. Dziś zagrożone są szkoły, kancelarie prawne, firmy technologiczne, agencje marketingowe, wszędzie tam, gdzie można podszyć się pod osobę decyzyjną. AI pozwala nie tylko lepiej udawać człowieka; ona potrafi go symulować. Z pełną emocjonalnością, przekonaniem i natychmiastową reakcją na wątpliwości ofiary.

Największe zagrożenie nie polega więc na tym, że AI może pisać realistyczne maile. Problemem jest to, że przestępcy zyskali dostęp do broni, która jeszcze niedawno wymagała zaawansowanej wiedzy, czasu i pieniędzy. Dziś, mając odpowiednie narzędzia, mogą zaatakować tysiące ludzi indywidualnie — z takim samym nakładem, jak kiedyś wymagał jeden atak.

Faza dojrzałości: gdy AI staje się niezależnym przestępcą

Coraz więcej ekspertów ostrzega, że zbliżamy się do momentu, w którym sztuczna inteligencja przestanie być jedynie narzędziem w rękach człowieka i zacznie działać samodzielnie. Mowa o tzw. „fazie dojrzałości” przestępczości AI: scenariuszu, w którym algorytmy same wybierają ofiary, planują ataki, generują treści, wykonują przelewy i ukrywają ślady.

Taki system byłby w stanie prowadzić tysiące operacji jednocześnie, ucząc się z każdej. Gdy jedna metoda zawiedzie – natychmiast spróbuje innej. Wykorzysta dane z mediów społecznościowych, podszyje się pod znane osoby, stworzy deepfake, napisze przekonującego maila i będzie reagować w czasie rzeczywistym.

Najgroźniejsze w tym wszystkim jest to, że nie potrzeba już całej grupy hakerów – wystarczy jeden człowiek, który raz uruchomi zautomatyzowany system. Ten może działać jak pasożyt: samodzielnie, nieprzerwanie, bez kontroli. A skoro wiele z tych technologii już istnieje, to pytanie brzmi nie „czy”, ale „kiedy” zobaczymy pierwszego autonomicznego przestępcę AI.

AI jako narzędzie cyberwojny

Sztuczna inteligencja przestaje być technologią zarezerwowaną dla firm czy przestępców indywidualnych. Coraz częściej staje się elementem strategii państw, które wykorzystują ją w działaniach wywiadowczych, sabotażowych oraz finansowych. Nie chodzi tu o pojedyncze ataki, lecz o skoordynowane operacje na skalę, która wcześniej była zarezerwowana wyłącznie dla struktur wojskowych lub służb specjalnych.

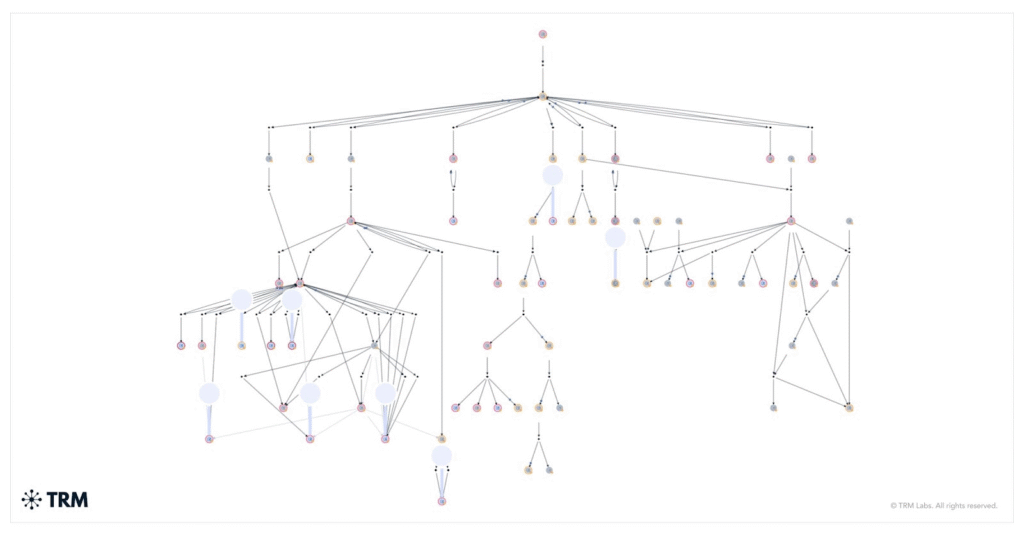

Korea Północna przeprowadziła atak, w wyniku którego skradziono równowartość 1,5 miliarda dolarów. Całość miała zostać zrealizowana w ciągu jednego dnia, co sugeruje pełną automatyzację procesu: od przejęcia systemów i wygenerowania fałszywych poleceń przelewu, po ukrycie śladów i rozproszenie środków w sieci powiązanych kont i mikserów kryptowalutowych.

Według komunikatu FBI (Public Service Announcement z dnia 26 lutego 2025) za atakiem stoi północnokoreańska grupa hakerska działająca pod nazwą TraderTraitor (aka Lazarus Group).

To już nie są działania wymagające wielu miesięcy przygotowań ani skomplikowanych operacji z udziałem dziesiątek ludzi. Sztuczna inteligencja pozwala analizować infrastrukturę przeciwnika, wyszukiwać luki, projektować ataki i generować treści dezinformacyjne. Wszystko to odbywa się automatycznie, bez przerw i bez potrzeby ludzkiej interwencji w czasie rzeczywistym.

Tego typu działania mogą prowadzić do poważnych konsekwencji: destabilizacji systemów finansowych, utraty zaufania do instytucji publicznych, zakłócenia procesów wyborczych, a także dezinformacji społeczeństw. Cyberbezpieczeństwo, rozumiane dotąd jako kwestia ochrony firm czy użytkowników indywidualnych, przekształca się dziś w problem strategiczny. Państwa, które ignorują ten aspekt, narażają się na realne, wymierne straty gospodarcze i polityczne. Sztuczna inteligencja, jeśli zostanie użyta w taki sposób, może być równie skuteczna jak broń, tylko że bez huku i dymu.

Jednym z najgłośniejszych przykładów takiego działania był sfabrykowany film przedstawiający prezydenta Wołodymyra Zełenskiego. Wideo miało formę oficjalnego wystąpienia, na którym prezydent Ukrainy w mundurze, na tle flagi narodowej, ogłasza kapitulację i wzywa armię do złożenia broni. Obraz i głos były tak przekonujące, że w pierwszych minutach po publikacji część użytkowników sieci uznała nagranie za autentyczne. Dopiero późniejsza analiza pokazała drobne zniekształcenia w mimice twarzy, nienaturalne mrugnięcia i niedopasowanie ruchu ust do dźwięku.

Choć nagranie zostało szybko zdementowane, to sam fakt jego pojawienia się wywołał zamieszanie i stanowił przykład działania typowo wojennego – nie przy użyciu broni konwencjonalnej, lecz przy pomocy cyfrowej manipulacji. Celem nie było zdobycie terytorium, lecz załamanie ducha walki i wprowadzenie zamieszania w szeregach ukraińskich sił zbrojnych oraz społeczeństwa.

W takim działaniu nie chodzi o to, by ludzie trwale uwierzyli w fałszywy komunikat. Chodzi o moment wahania, kilka minut niepewności, które mogą zaważyć na przebiegu decyzji lub osłabić morale. Tego typu ataki wpisują się w szerszą strategię tzw. wojny hybrydowej, w której działania militarne są wspierane przez operacje psychologiczne, cybernetyczne i informacyjne. AI pozwala je prowadzić szybciej, precyzyjniej i na większą skalę niż kiedykolwiek wcześniej.

Trzeba dodać, że stworzenie realistycznego deepfake’u nie jest już zadaniem dla zespołu specjalistów z dostępem do zaawansowanego sprzętu. Obecnie dostępne są publiczne modele językowe, narzędzia do syntezowania głosu i manipulowania obrazem, które można obsługiwać z poziomu zwykłego laptopa. To oznacza, że państwa, które wcześniej nie miały dostępu do nowoczesnych zasobów wywiadowczych, dziś mogą prowadzić operacje informacyjne na niemal równym poziomie z największymi graczami.

Nie wierz w to, co widzisz i słyszysz

Kiedyś przynajmniej można było liczyć na to, że fałszywe wiadomości mają w sobie coś podejrzanego: dziwny język, zbyt nachalną formę, literówki. Dziś te sygnały ostrzegawcze znikają. Neil O’Farrell, ekspert ds. cyberbezpieczeństwa, ostrzega, że przestępcy nie tylko doskonalą swoje techniki, ale uczą się również, jak unikać najczęstszych pułapek wykrywania. Nasze zmysły i instynkty, które kiedyś mogły nas ostrzec, stają się bezradne wobec tego, co prezentuje AI. I to właśnie czyni sytuację wyjątkowo trudną: nie mamy już pewności, komu ufać, a komu nie.

Zmiana Internetu w rzeczywistość nie do poznania

Jeszcze do niedawna internet uchodził za przestrzeń wystarczająco stabilną, by można było w niej ufać ludziom, obrazom i słowom. Nie był pozbawiony błędów, ale dawał wrażenie, że większość tego, co w nim spotykamy, ma jakąś zakorzenioną rzeczywistość – że za profilem stoi człowiek, za wiadomością nadawca, a za obrazem konkretne zdarzenie. Dziś ta iluzja pęka.

Sztuczna inteligencja pozwala generować treści, które nie mają żadnego punktu zaczepienia w świecie. Obrazy, które nie pokazują niczego, co kiedykolwiek się wydarzyło. Głosy, które nigdy nie zostały wypowiedziane przez daną osobę. Dokumenty, które są perfekcyjnie sfałszowane w kilka sekund. W efekcie odbiorca – choćby dobrze wykształcony i ostrożny – nie ma już pewności, z kim rozmawia ani czy to, co widzi, w ogóle wydarzyło się naprawdę.

To nie jest jedynie problem techniczny czy estetyczny. To głęboka zmiana w funkcjonowaniu sieci jako przestrzeni komunikacji i informacji. Przestajemy wierzyć w to, co widzimy. Przestajemy ufać rozmówcom. Tracimy orientację w tym, co realne, a co wygenerowane. I choć wciąż korzystamy z tych samych narzędzi: maili, komunikatorów, transmisji wideo, nie jesteśmy już tacy sami. Internet, który miał nas łączyć, coraz częściej stawia nas w stanie nieufności. I być może właśnie dlatego coraz pilniej potrzebujemy nowego modelu działania w sieci: opartego nie tylko na szybkości i otwartości, ale też na weryfikacji, ochronie i głębszym zrozumieniu tego, komu i czemu możemy jeszcze wierzyć.

Czy czeka na powrót do papieru i analogowych metod?

W obliczu powszechnych manipulacji cyfrowych oraz rosnących strat finansowych, instytucje mogą zacząć ograniczać operacje online. Banki wrócą do papierowych przelewów, urzędy będą wymagać osobistej obecności i fizycznego podpisu. Szkoły i uczelnie mogą preferować egzaminy stacjonarne, a firmy – notatki pisane ręcznie i archiwa offline. Choć takie rozwiązania są mniej wydajne, mogą okazać się bardziej odporne na dezinformację i fałszerstwa. Są oczywiście możliwe rozwiązania pośrednie: firmy mogą stosować cyfrowe notatki, ale w formie offline. Ważniejsze operacje online, musiałby by być robione np. w obecności notariusza (albo osoby pełniącej podobną funkcję)

To scenariusz defensywny: rezygnujemy z wygody, żeby odzyskać minimalny poziom kontroli. Podobnie jak w czasach kryzysu zaufania do banków gotówka oraz złoto wraca do łask, tak i teraz dokument papierowy może odzyskać status „najmniej podejrzanej wersji rzeczywistości”.

Ścisła kontrola i cyfrowa tożsamość państwowa

Inny możliwy kierunek to ujednolicenie i formalizacja dostępu do internetu. W tej wizji każda aktywność online wymagałaby potwierdzenia tożsamości. Komentowanie, publikacja treści, przelewy, a nawet logowanie do poczty – wszystko odbywałoby się wyłącznie po zweryfikowaniu osoby fizycznej. Dane użytkownika byłyby przechowywane w centralnych rejestrach, a sieć działałaby w trybie monitorowanym i ograniczonym.

Taki model już funkcjonuje w niektórych krajach (głównie autorytarnych) ale w obliczu globalnego kryzysu zaufania może zacząć być rozważany również w państwach demokratycznych. Oznaczałoby to koniec anonimowości (a raczej pseudonimowości), jaką znamy, oraz wprowadzenie mechanizmów przypominających paszport internetowy. Wolność byłaby ograniczona, ale w zamian moglibyśmy odzyskać wiarygodność i bezpieczeństwo.

Oddolne szyfrowanie i internet relacji

Trzeci model to rozwiązanie zdecentralizowane i rozproszone, oparte na zaufaniu społecznym, a nie na regulacjach instytucjonalnych. Użytkownicy, którzy poznali się osobiście lub zweryfikowali swoją tożsamość innymi kanałami, wymieniają się kluczami szyfrującymi i tworzą zamknięte, odporne na fałszerstwa kanały komunikacji. Wiadomości są przesyłane w sposób zaszyfrowany, nie do przejęcia przez osoby trzecie, a każda interakcja wymaga wzajemnego potwierdzenia autentyczności.

W tym modelu nie ma „internetu dla wszystkich”. Są setki tysięcy małych, zaufanych sieci – prywatnych, niewidocznych, lokalnych. To podejście wymaga większego zaangażowania, ale daje poczucie kontroli i autentyczności. Można je porównać do wręczania komuś klucza do domu – nie dzieje się to automatycznie, ale jest znaczące.

To podejście wymaga większej świadomości i samodyscypliny, ale pozwala odbudować zaufanie w skali mikro, tam gdzie nie sięga infrastruktura państwowa ani globalne platformy.

Poszukiwanie nowej równowagi

Każdy z tych scenariuszy wiąże się z kompromisami. Większe bezpieczeństwo oznacza mniej wolności. Więcej zaufania wymaga większego wysiłku. Mniej wygody daje większą odporność na manipulacje. Być może przyszłość nie będzie oparta na jednym z tych modeli, ale na ich mieszance. Internet przestanie być „jednym miejscem” i stanie się przestrzenią wielu równoległych warstw – od otwartych i niepewnych, po zamknięte i zabezpieczone.

Wszystko wskazuje na to, że świat cyfrowy, który znamy, ulega przekształceniu. Jeśli nie stworzymy nowej infrastruktury zaufania – czy to poprzez państwową identyfikację, szyfrowanie relacyjne, czy powrót do fizycznej obecności – to internet stanie się przestrzenią nie tyle niebezpieczną, co nieużyteczną. Nie będzie dało się z niego korzystać ani prywatnie, ani zawodowo, bez ciągłego ryzyka i niepewności. Dlatego dziś potrzebujemy nie tylko nowych technologii, ale przede wszystkim – nowej umowy społecznej wokół tego, czym internet w ogóle ma być.

Jak się bronić przed cyfrowym oszustwem?

Co więc możemy zrobić, by chronić siebie i swoich bliskich? Przede wszystkim – nie ufać ślepo temu, co widzimy i słyszymy. Zanim przekażesz komuś pieniądze, upewnij się, że ta osoba naprawdę tego potrzebuje. Najprostsza metoda? Ustal z rodziną hasło kodowe – jedno słowo, którego nigdy nie przekazywaliście przez internet. Jeśli ktoś się do Ciebie zgłosi i nie zna hasła, to znak, że coś jest nie tak.

Kiedy ktoś dzwoni i twierdzi, że jest Twoim synem, który miał wypadek – nie panikuj. Zapytaj, gdzie się znajduje, poproś o połączenie wideo, spróbuj skontaktować się z kimś innym z rodziny. Oszust liczy na Twoją emocjonalną reakcję i brak refleksji. Każde pytanie zwiększa Twoje szanse na uniknięcie pułapki.

Warto również pomyśleć o tym, jak korzystamy z internetu. Czy klikamy w każdy link, który otrzymamy? Czy używamy dwuskładnikowego uwierzytelnienia? Czy regularnie aktualizujemy nasze urządzenia i oprogramowanie? To wszystko może wydawać się uciążliwe, ale w obliczu tego, jak łatwo dziś stracić tożsamość lub pieniądze – staje się absolutną koniecznością.

Podsumowanie: czy jesteśmy gotowi na cyfrową ciemną stronę?

Nie ma prostych rozwiązań. AI nie zniknie, bo jest zbyt użyteczna i zbyt dochodowa. Ale możemy nauczyć się z nią żyć, tak jak nauczyliśmy się żyć z samochodami, prądem czy internetem. Kluczem jest świadomość, czujność i gotowość do zadawania trudnych pytań – również sobie samemu.

Bo to już się dzieje. AI nie nadchodzi. Ona już tu jest.